2019-10-5 11:26 |

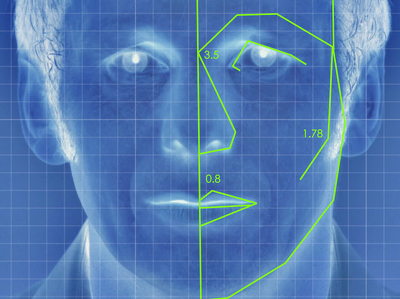

Ученые из Центра компетенций НТИ "Центр технологий распределенных реестров СПбГУ" создали программное обеспечение на основе нейросетей, которое способно распознавать нежелательный контента, в том числе в видеопотоке. Об этом ...

Аналог Ноткоин - TapSwap Получай Бесплатные Монеты

Подробнее читайте на gazeta.ru